Künstliche IntelIigenz (KI) ist zurzeit das Schlagwort schlechthin – egal, wohin man auch schaut. Das Tempo der Entwicklung dieser Technologie ist rasant und macht nicht wenigen Angst. Was kommt auf uns zu? Sind wir in Schule und Gesellschaft darauf vorbereitet?

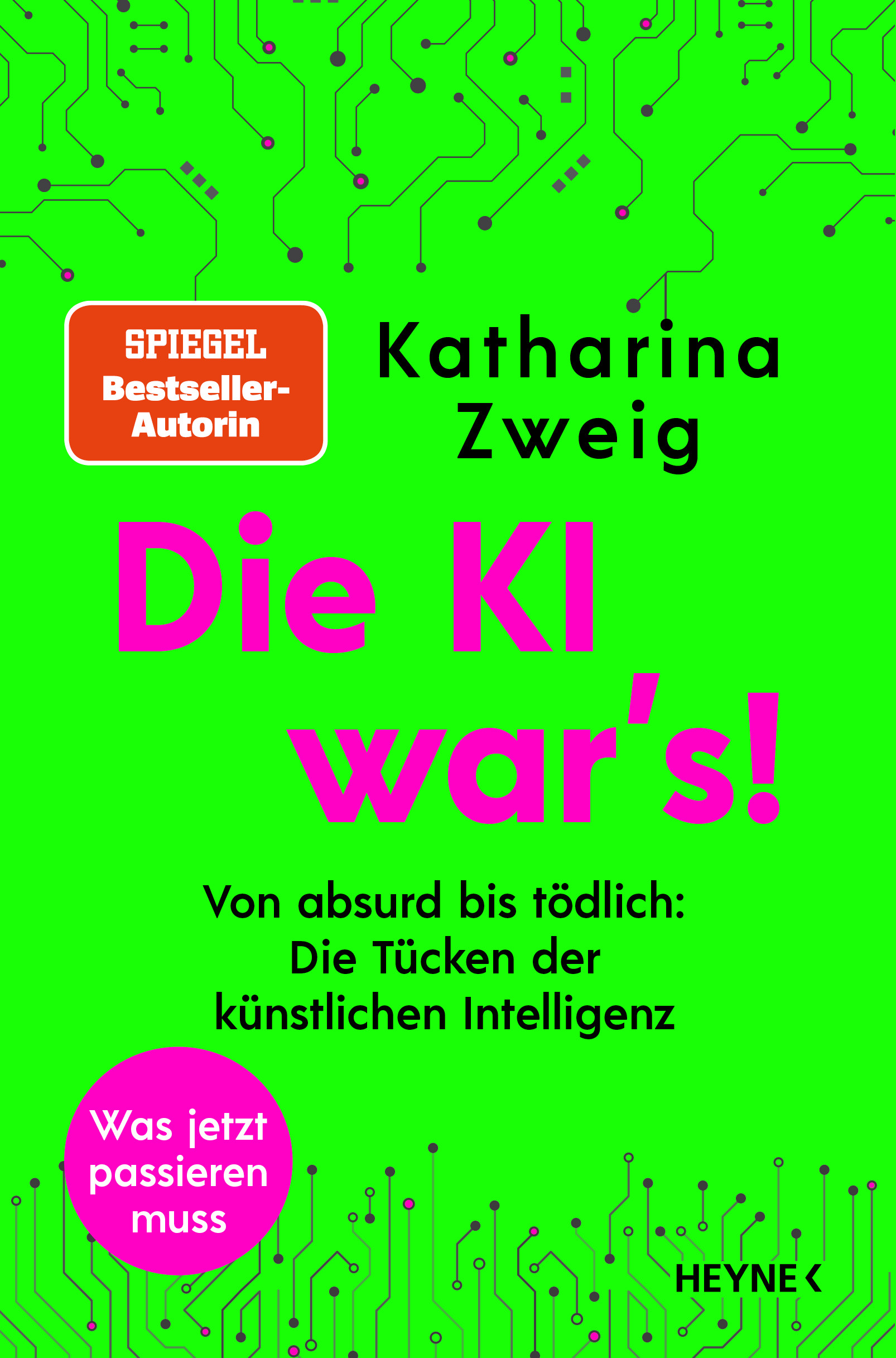

Grund genug, dass wir uns darüber mit Prof. Katharina Zweig unterhalten. Als renommierte Expertin leitet sie u. a. an der TU Kaiserslautern das Algorithm Accountability Lab und ist Autorin mehrerer Bücher. So erscheint im September ihr neuer Titel „Die KI war’s!: Von absurd bis tödlich: Die Tücken der künstlichen Intelligenz.“

Der Begriff KI ist aktuell in aller Munde. Was verbirgt sich hinter diesem Begriff? Kann man ihn in wenigen Worten erläutern?

Im Moment versteht man unter KI vor allem solche Systeme, die aus Daten der Vergangenheit lernen, um Entscheidungen für die Zukunft zu treffen. So kann man zum Beispiel in Daten von Kreditnehmern nach Mustern für Risiken suchen, die dazu führen, dass ein Kredit nicht zurückgezahlt wird. Mit dem Muster kann man dann über neue Kreditanträge entscheiden.

Was müssen wir „Nicht-ITler“ über und von KI verstehen?

Aktuell wird KI oft als Heilsbringer missverstanden, als magische Zutat, um die komplexe Welt endlich verständlich zu machen. Dabei hängt der Erfolg des Lernens aber stark von der Menge und Qualität der Daten ab – und wie genau sie trainiert wird bzw. wie genau die Maschine lernt. Das Trainieren der Maschine umfasst dabei alles, was der Mensch tut, damit die Maschine „lernt“.

Was die KI lernt

Wie kann man sich das Trainieren der KI vorstellen?

Bei der Bilderkennung ist das am einfachsten zu erklären: Man sucht viele Bilder zusammen, die möglichst auch eine Beschreibung haben. Bei flickr werden Nutzer:innen beispielsweise gebeten, Bilder zu labeln, also Stichworte zu geben, die beschreiben, was auf dem Bild zu sehen ist. Mit diesen Bildern und ihren Labeln kann eine Maschine dann trainiert werden, d. h., sie versucht mit mathematischen Methoden Muster auf diesen Bildern zu finden, die nach „Pferd“ oder „Hund“ aussehen. Technisch gesehen bedeutet „lernen“ dabei, dass die Maschine gewichtet, welche Bildinformationen besonders wichtig sind. Wenn die Beispiele gut genug sind, kann das System dann später auf anderen Bildern ebenfalls Pferde und Hunde erkennen.

Lassen Sie uns nun konkreter mit dem ChatBot ChatGPT beschäftigen. Was kann diese KI?

ChatGPT ist eine generative KI. Unter diesem Begriff versteht man KI-Systeme, die Neues schaffen. Im Falle von ChatGPT wird aus einer Anfrage, einem sogenannten prompt, ein neuer Text generiert. Andere Beispiele generativer Systeme sind bild- oder videogenerierende KI-Systeme. Auch diese starten mit einem Prompt und erzeugen dann das entsprechende Medium.

Das zugrundeliegende Sprachmodell GPT (generative pre-trained transformer) ist eine spezielle Art von neuronalem Netzwerk, das enorme Mengen von Texten im Training verarbeitet hat.

Dabei wurde immer wieder ein Wort weggenommen und die Maschine sollte lernen, dieses Wort zu erraten. Das macht unser Gehirn auch ständig, wenn wir miteinander sprechen: Wir ahnen das nächste Wort vorher.

Die Maschine ist sehr gut darin geworden, in fast beliebigen Kontexten Wörter zu erraten, die mit diesem Kontext zusammenhängen. So kann ChatGPT passende Texte zu Prompts erstellen. Fakten sind ihm dabei aber egal, da es keine dahinterliegende Wissensdatenbank gibt. ChatGPT würde z. B. den Satz „Der aktuelle Kanzler in Deutschland ist Robert Habeck“ produzieren können, weil die Wörter „Robert Habeck“ oft im Kontext von „Kanzler von Deutschland“ zu lesen sind. Dass Habeck der Vizekanzler ist, „weiß“ ChatGPT nicht.

Lügt ChatGPT?

Also, dass ChatGPT nicht faktentreu ist, ist ja auf jeden Fall klar. Aber lügen kann es nicht, da es kein Mensch, kein Wesen ist. ChatGPT assoziiert Texte zusammen – die oft richtig sind, es aber nicht sein müssen. Das ist keine Lüge, sondern ein Unvermögen. Wenn man ChatGPT zum Beispiel fragt, ob ein Xavier Yang Rodriguez eine Wikipediaseite hat, dann kreiert die Software eine URL, die so aussieht wie die von Wikipedia – die Seite selbst gibt es aber gar nicht.

Was die KI kann

Welche Chancen bietet uns ihr Einsatz? Wie können positive oder auch entlastende Nutzungsszenarien aussehen?

Ich persönlich finde es entlastend, wenn meine Studierenden damit ihre (selbst geschriebenen) Texte polieren: Dann stimmt jedes Komma und die Grammatik auch. Man kann damit auch hervorragend Ideen generieren lassen: „Generiere mir 10 Titel für meinen nächsten Artikel“. Das geht auch für Hausaufgaben: „Generiere mir 10 Multiplikationsaufgaben für Viertklässler“. Aber korrigieren kann ChatGPT die Antworten darauf natürlich nicht. Es „versteht“ nicht, was eine Multiplikation ist, aber weiß, dass auf zwei Zahlen mit einem Multiplikationszeichen ein Gleichheitszeichen kommt und dann eine weitere Zahl. Wie die zusammenhängen, weiß es allerdings nicht.

Könnten Sie kurz noch ein wenig genauer erläutern, was genau sie eben nicht kann?

Die Maschine hat kein Bewusstsein, kein Weltwissen – sie hat gezählt, wann welche Wörter in welchem Kontext sehr wahrscheinlich zu finden sind. Damit kann man großartige Dinge tun, aber eben nichts, wo es auf einen faktisch korrekten Text ankommt. Das kann sie nicht. Zudem würde ich ChatGPT aus psychologischen Gründen nicht für sehr emotionale Texte verwenden – einen Trauerbrief vollständig von ChatGPT schreiben zu lassen, fände ich persönlich respektlos. Sich inspirieren zu lassen, hingegen nicht. Der Übergang ist da natürlich fließend.

Welche Risiken sehen Sie?

Ich lese immer wieder in den Medien Sätze wie: „ChatGPT kann Hausaufgaben erledigen“, „ChatGPT kann Texte bewerten“. Beides stimmt so nicht! Richtig ist aber, dass bei Anfragen solcher Art Texte herauskommen, die auf den ersten Blick sehr überzeugend wirken können. Hier ist es wichtig, dass Lehrer:innen genauso wie ihre Schüler:innen über die zugrundeliegende Technologie aufgeklärt werden. Dann ist auch klar, was sie kann und was sie nicht kann.

Lässt sich aus Ihrer Sicht prognostizieren, welche mittelfristigen gesellschaftlichen Folgen der Einsatz von KI haben wird? Werden z. B. Jobs in ganzen Branchen wegfallen? Neue dafür entstehen?

Solange wir über „die KI“ sprechen, ist es schwierig, sich vorzustellen, was alles passieren könnte. Es ist einfacher, wenn man einmal nur über eine der vielen Technologien nachdenkt, die KI ermöglicht: z. B. die spontane Übersetzung von allen EU-Mitgliedssprachen. Was heißt das, wenn man nach Mallorca in den Urlaub fliegt und plötzlich auf Spanisch mit jedem sprechen kann? Wie viele neue Geschäftsmodelle sind damit möglich, wie groß ist der neue Markt für kleinere Unternehmen in Deutschland? Brauchen wir dann weniger Übersetzer oder eher mehr, weil sich plötzlich ganz viele Geschäfte trauen, ihre Webseiten in alle möglichen Sprachen zu übersetzen – um dann gezielt Hilfe zu erbitten bei der Übersetzung von AGBs und anderen, rechtlichen Texten? Hier, im Kleinen, sieht man besser, was alles passieren könnte. Und man erkennt auch, dass jegliche Vorhersagen auf sehr vielen Annahmen beruhen. Aber ich bin insgesamt optimistisch und glaube, dass mehr Arbeitsplätze entstehen.

KI im Unterricht

Thema Schule: Welche Kompetenzen im Einsatz von KI benötigen Lehrer:innen? Was muss den Schüler:innen vermittelt werden? Thema Nutzungskompetenz

Lehrer:innen brauchen aus meiner Sicht eine Einführung in „Das kleine ABC der Informatik“: von A wie Algorithmus über B wie Big Data zu C wie Computerintelligenz, also KI. Dann würden sich auch viele Ängste erledigen, denn Lehrer:innen sind bis auf Weiteres nicht ersetzbar. Wir führen solche Workshops vielfach in anderen Berufen durch und danach ist die Sicht auf KI viel realistischer.

Wie könnten Einsatzszenarien in der Schule aussehen?

Ich persönlich habe das Gefühl, dass man mit den Systemen relativ gut Sprachen lernen kann, sobald man eine gewisse Basis hat.

Die Systeme sind geduldig, sprechen fast immer fehlerfrei und können sprachliche Fehler oftmals korrigieren. Man kann sich mit ihnen über sein jeweiliges Lieblingsthema unterhalten: der eine über Fußball, die andere über Programmierung, der nächste über Tiere. Lehrer:innen können sie aber auch für die Vorbereitung von Unterrichtsmaterialien nutzen: „Erstelle einen Multiple-Choice-Test zum Thema XY“ oder man lässt mit der KI einen faktisch fehlerhaften Text erstellen, in dem die Schüler:innen die Fehler finden sollen.

Lässt es sich überprüfen, ob Hausaufgaben oder eine Hausarbeit mit der KI geschrieben wurde?

Ja – daran, dass plötzlich die Grammatik und Zeichensetzung stimmt. Nein, im Ernst: Es lässt sich nicht verlässlich, und schon gar nicht gerichtsfest, erkennen, ob eine Hausaufgabe mit einem solchem System geschrieben wurde. Das geht bei einem Rechenergebnis ja auch nicht: Ob nun der Taschenrechner geholfen hat oder nicht, finden wir genauso wenig heraus. Hier hilft nur Aufklärung bei den Schüler:innen, wann sie mit solchen Systemen sinnvoll arbeiten können.

Dürfen Maschinen entscheiden

Nochmals zurück zu den Einsatzszenarien der KI. In nicht wenigen Zusammenhängen wird sie auch verwendet, um automatisiert Entscheidungen zu treffen. Könnten Sie uns hier bitte ein-zwei Beispiele geben.

KI-Systeme werden in den USA an manchen Stellen vor Gericht verwendet, um vorherzusagen, ob ein Krimineller oder eine Kriminelle rückfällig werden wird. Andere Systeme sollen helfen, Verdächtige auf Fotos zu identifizieren. Damit wurde beispielsweise fälschlich der Familienvater Robert Williams des Uhrendiebstahls bezichtigt.

Wie problematisch wird es, wenn Maschinen entscheiden?

Es wird dann problematisch, wenn sie Berechnungen anstellen, die nicht auf anderem Wege verifiziert werden können. Robert Williams hatte glücklicherweise ein wasserfestes Alibi und konnte zu dem Zeitpunkt nicht an dem Ort des Diebstahls gewesen. Die Rückfälligkeitsprognose gehört aber zu diesen Fällen, wo es schwierig wird, die Behauptung zu bewerten. Zusätzlich verändert das Ergebnis der Maschine unter Umständen die Zukunft der beurteilten Person: Wird sie aufgrund einer zu hohen Risikoberechnung eingesperrt, kann sie nicht beweisen, dass sie NICHT wieder rückfällig geworden wäre. Tatsächlich verschlechtert sich ihre Lebenslage enorm, sodass sie vielleicht nach der Entlassung wieder rückfällig wird, gerade weil sie eingesperrt wurde. Bei solchen Fragen müssen wir also sehr gut evaluieren, ob hier Menschen oder Maschinen bessere Entscheidungen treffen.

Wie sollte hier eine Regulierung aussehen? Ist sie notwendig?

Aus meiner Sicht sollten risikoberechnende Systeme nur mit wissenschaftlicher Evaluation eingesetzt werden dürfen – so sieht es die kommende europäische KI-Verordnung auch vor. Wenn sie wirklich besser sein sollten als menschliche Entscheider, sollte man sich aber auch fragen: Woran liegt das? Wo liegt die Information, die Menschen bisher nicht oder nicht richtig beachtet haben? Denn dann könnten wir daraus lernen und vielleicht auch als Menschen bessere Entscheidungen treffen.

Oft liest man, dass – wenigstens sprachlich – der KI ein „Bewusstsein“ zugesprochen wird. Auch wenn ich mir sicher bin, dass Sie dies nicht unterschreiben, fordern Sie ein neues Wissenschaftsfeld, das mit angepassten Methoden aus Verhaltensforschung und Psychologie das Verhalten von Computern untersucht. Warum brauchen wir dies?

Bisher hat aus meiner Sicht kein KI-System Bewusstsein – ich will aber nicht ausschließen, dass es das in Zukunft geben könnte. Nichtsdestotrotz erzeugen KI-Systeme Verhalten, dass sich uns nicht mehr direkt durch ihre Programmierung erschließt. Sie machen auch Fehler – manche ähnlich zu unseren, andere sind von ganz anderer Natur. Da wir diese Verhaltensfehler nicht über die Programmierung verstehen und korrigieren können, müssen wir sie beobachtend analysieren – ähnlich wie bei Tieren und Menschen.

Als Ausblick: Welche Kompetenzen brauchen wir und sollten wir den Schüler:innen in Schulen vermitteln, damit die Beziehung Mensch – KI in Zukunft erfolgreich gelingen kann?

Zuallererst brauchen alle ein Verständnis dafür, was diese neue Technologie kann und was nicht. Genau dafür habe ich meine Bücher geschrieben, um dieses Grundlagenwissen zu vermitteln. Danach muss man sich überlegen, ob in einer bestimmten Situation wirklich eine KI-Technologie die bestmögliche Wahl ist oder nicht doch ein klassisches Softwaresystem. Denn die klassischen Lösungen erlauben es, das Verhalten des Systems von der Programmierung her zu verstehen. KI-Systeme müssen dagegen beobachtend in ihrem Verhalten analysiert werden – da bleiben also mehr Fragen zu ihrer Zuverlässigkeit offen.

Das Gespräch führte Jörg Schmidt.

Die KI war's!

Informationen zum neuen Buch von Katharina Zweig und eine Bestellmöglichkeit findest du hier.

Am 18. Oktober 2023 wird Prof. Dr. Katharina Zweig beim #excitingedu Kongress in Berlin eine Keynote zum Thema „Schule ohne Lehrkräfte? – Was KI leisten kann (und was nicht)!“ halten.

Alle Informationen zum Kongress findest du unter excitingedu-kongress.de.